周四,AI 托管平台 Hugging Face 的 AI 模型列表首次突破 100 万个,标志着快速扩张的机器学习领域的一个里程碑。人工智能模型是一种计算机程序(通常使用神经网络),根据数据进行训练以执行特定任务或做出预测。该平台于 2016 年作为聊天机器人应用程序启动,并于 2020 年成为人工智能模型的开源中心,现在为开发人员和研究人员提供了广泛的工具。

机器学习领域代表着一个远比大型语言模型 (LLM) 更大的世界,比如为 ChatGPT 提供支持的那种模型。在 X 上的一篇文章中,Hugging Face 首席执行官 Clément Delangue 介绍了他的公司如何托管许多备受瞩目的 AI 模型,例如“Llama、Gemma、Phi、Flux、Mistral、Starcoder、Qwen、Stable 扩散、Grok、Whisper、Olmo、Command” 、Zephyr、OpenELM、Jamba、Yi”,还有“999,984 个其他”。

德兰格说,原因在于定制。 “与‘1 模型统治一切’的谬论相反,”他写道,“针对您的用例、您的领域、您的语言、您的硬件以及一般的约束条件的较小的专门定制优化模型会更好。事实上,很少有人意识到,Hugging Face 上几乎有同样多的模型仅对一个组织私有——供公司私下构建人工智能,专门针对他们的用例。”

Hugging Face 转型为主要的人工智能平台,伴随着整个科技行业人工智能研发步伐的加快。在短短几年内,该网站上托管的模型数量随着对该领域的兴趣而急剧增长。在 X 上,Hugging Face 产品工程师 Caleb Fahlgren 在平台上发布了每月创建的模特图表(以及其他图表的链接),并表示:“模特数量逐月呈指数级增长,而 9 月还没有结束。”

微调的力量

正如 Delangue 上面所暗示的,平台上模型的绝对数量源于平台的协作性质以及针对特定任务微调现有模型的实践。微调意味着采用现有模型并对其进行额外的训练,以向其神经网络添加新概念并改变其产生输出的方式。来自世界各地的开发者和研究人员贡献他们的成果,形成了一个庞大的生态系统。

例如,该平台托管 Meta 的开放权重 Llama 模型的许多变体,这些变体代表原始基本模型的不同微调版本,每个版本都针对特定应用程序进行了优化。

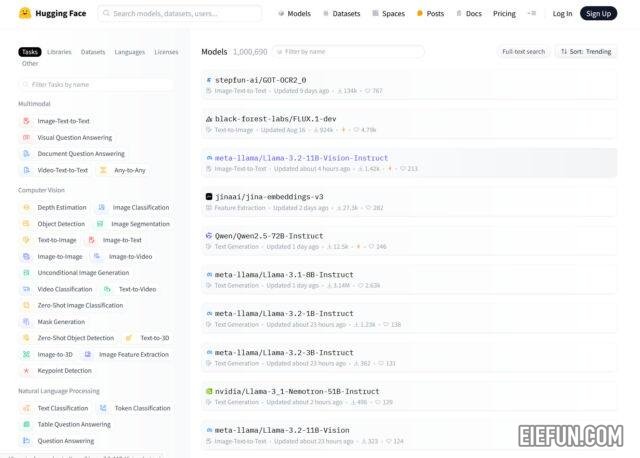

Hugging Face 的存储库包含适用于各种任务的模型。浏览其模型页面会在“多模式”部分下显示图像到文本、视觉问答和文档问答等类别。在“计算机视觉”类别中,还有深度估计、对象检测和图像生成等子类别。还展示了文本分类和问答等自然语言处理任务,以及音频、表格和强化学习 (RL) 模型。

当按“最多下载”排序时,Hugging Face 模型列表揭示了人们认为最有用的 AI 模型的趋势。位居榜首的是麻省理工学院的 Audio Spectrogram Transformer,它以 1.63 亿次下载量遥遥领先,它对语音、音乐和环境声音等音频内容进行分类。其次是来自谷歌的 BERT,下载量达到 5420 万次,这是一种人工智能语言模型,可以通过预测屏蔽单词和句子关系来学习理解英语,从而能够协助完成各种语言任务。

排名前五的 AI 模型均为 MiniLM-L6-v2(将句子和段落映射到 384 维密集向量表示,对于语义搜索很有用)、Vision Transformer(将图像处理为补丁序列以执行图像分类) ,以及 OpenAI 的 CLIP(它连接图像和文本,使其能够使用自然语言对视觉内容进行分类或描述)。

无论模型或任务是什么,平台都会不断发展。 “如今,HF 上每 10 秒就会创建一个新的存储库(模型、数据集或空间),”Delangue 写道。 “最终,模型将与代码存储库一样多,我们将为此而努力!”

版权声明

本文为本站原创内容,转载需注明文章来源(https://www.eiefun.com),另:文中部分素材可能会引用自其他平台,如有侵权或其它,请联系 admin@eiefun.com,我们会第一时间配合删除