目录它不需要互联网工作您可以使用HuggingsNap做什么?

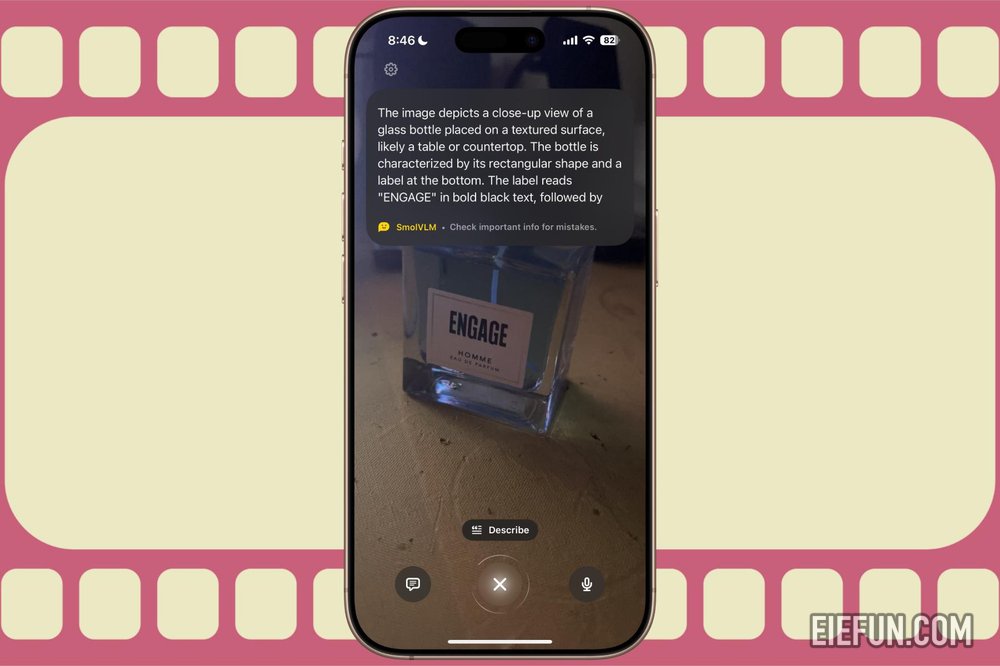

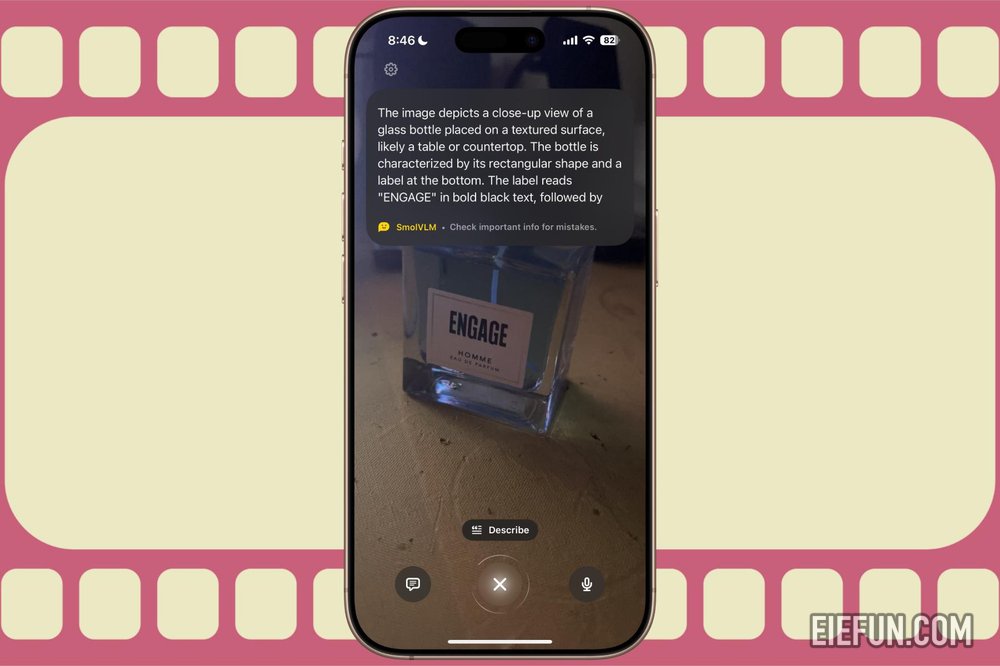

Hugging Face的机器学习平台发布了一个iOS应用程序,该应用程序将使您周围的世界有意义,如iPhone的相机所见。只需将其指向场景,或单击图片,它将部署AI来描述它,识别对象,执行翻译或提取基于文本的详细信息。

该应用程序命名为HuggingsNap,采用多模型方法来理解您周围的场景作为输入,现在可以在App Store上免费使用。它由Smolvlm2提供动力,Smolvlm2是一种开放的AI模型,可以将文本,图像和视频作为输入格式处理。

推荐的视频

该应用程序的总体目标是让人们了解周围的物体和风景,包括植物和动物识别。这个想法与iPhone的视觉智能没有太大的不同,但是HuggingsNap在其Apple竞争对手上具有至关重要的胜利。

请启用JavaScript查看此内容

它不需要互联网工作

在iPhone中运行的smolvlm2

它需要的只是运行iOS 18的iPhone,您可以走。 HuggingsNap的UI与您使用视觉智能所获得的ui没有太大不同。但是这里有根本的区别。

苹果依靠Chatgpt来使视觉智能工作。这是因为Siri目前无法像生成的AI工具那样表现,例如Chatgpt或Google的双子座,它们都有自己的知识库。取而代之的是,它可以将所有此类用户请求和查询的查询卸载。

这需要互联网连接,因为Chatgpt无法在离线模式下工作。另一方面,HuggingsNap效果很好。此外,离线方法意味着没有用户数据离开您的手机,从隐私角度来看,这始终是一个受欢迎的变化。

您可以使用HuggingsNap做什么?

HuggingsNap由通过拥抱脸开发的Smolvlm2模型提供动力。那么,这个模型可以在此应用程序背后运行该节目吗?好,很多。除了根据iPhone的相机看到的问题回答问题外,它还可以处理手机画廊中选择的图像。

例如,向其展示任何历史纪念碑的图片,并要求它给您旅行建议。它可以理解图表上出现的内容,或者根据文档从文档中获取的详细信息理解电费的图片并回答查询。

它具有轻巧的体系结构,特别适合AI的设备应用。在基准测试上,它的性能要比Google竞争的开放式Paligemma(3B)模型更好,并使用Alibaba的竞争对手QWEN AI模型擦肩而过。

最大的优点是它需要更少的系统资源来运行,这在智能手机的背景下尤其重要。有趣的是,流行的VLC媒体播放器还使用相同的SMOLVLM2模型来提供视频描述,让用户使用自然语言提示通过视频搜索。

它还可以从视频中明智地提取最重要的突出显示时刻。该应用程序的GitHub存储库说:“ Smolvlm是为了效率而设计的,可以回答有关图像的问题,描述视觉内容,创建基于多个图像的故事,或在没有视觉输入的纯语言模型上发挥作用。”

版权声明

本文为本站原创内容,转载需注明文章来源(https://www.eiefun.com),另:文中部分素材可能会引用自其他平台,如有侵权或其它,请联系 admin@eiefun.com,我们会第一时间配合删除