1958 年冬天,30 岁的心理学家弗兰克·罗森布拉特 (Frank Rosenblatt) 在从康奈尔大学前往华盛顿特区海军研究办公室的途中,停下来与一名记者喝咖啡。

罗森布拉特公布了一项非凡的发明,在计算的初期引起了不小的轰动。他宣称,这是“第一台能够拥有原创想法的机器”。

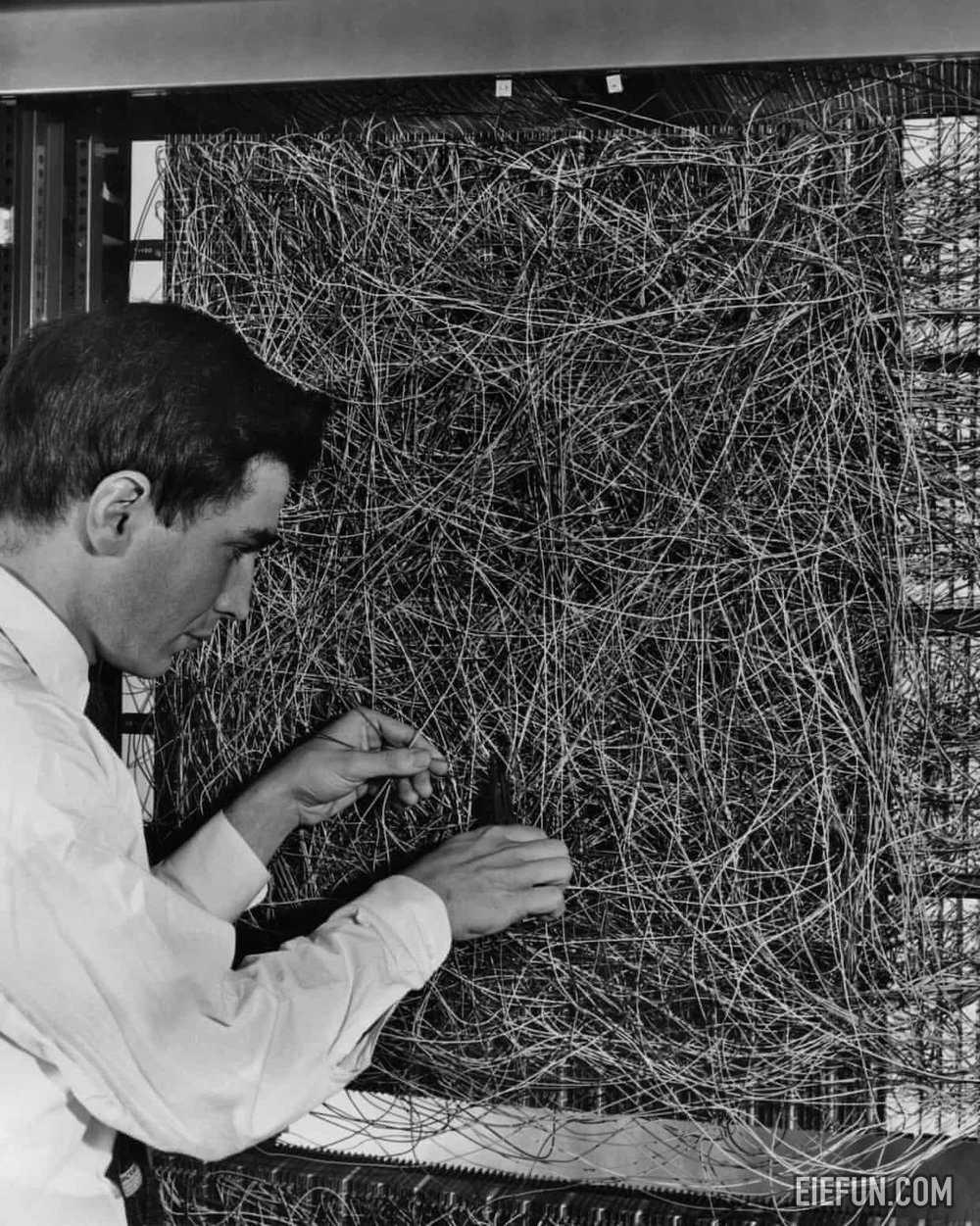

罗森布拉特的创意是感知机,这是一个受人类神经元启发的程序,在最先进的计算机上运行:一台重达五吨、墙大小的 IBM 大型机。向感知器提供一堆打孔卡,它可以学会区分左侧标记和右侧标记。暂时把这项任务的平凡性放在一边;机器能够学习。

罗森布拉特相信这是一个新时代的黎明,《纽约客》显然也同意这一点。 “在我们看来,它是人类大脑的第一个真正的竞争对手,”这位记者写道。当被问及感知器不能做什么时,罗森布拉特提到了爱、希望和绝望。 “简而言之,人性,”他说。 “如果我们不理解人类的性欲,为什么我们应该期望机器能够理解呢?”

感知器是第一个神经网络,是现代人工智能 (AI) 背后更为复杂的“深层”神经网络的基本版本。

但近 70 年过去了,人类大脑仍然没有真正的对手。 “我们今天拥有的是人造鹦鹉,”伦敦艾伦图灵研究所首席科学家马克吉罗拉米教授说。 “这本身就是一个了不起的进步,它将为我们提供造福人类的伟大工具,但我们不要逃避现实。”

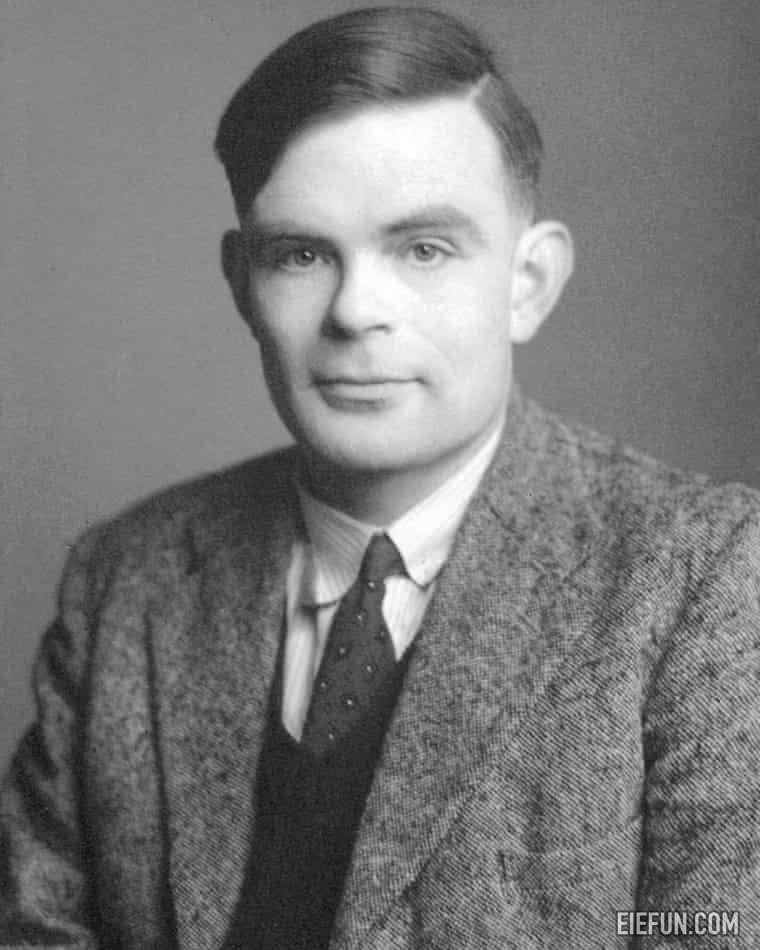

人工智能的历史,至少今天所写的,不乏父亲。许多人生育了相同的后代。罗森布拉特有时被称为深度学习之父,这一称号与另外三位男士共享。艾伦·图灵是布莱奇利公园的战时密码破译者和计算机科学的创始人,被认为是人工智能之父。他是最早认真对待计算机可以思考这一想法的人之一。

在 1948 年的一份报告《智能机械》中,图灵调查了机器如何模仿智能行为。他沉思道,通往“思维机器”的一条途径是用机器代替人的部件:用摄像头代替眼睛,用麦克风代替耳朵,以及“某种电子大脑”。图灵打趣道,为了自己找出答案,机器“应该被允许在乡村漫游”。 “对普通公民来说,危险将是严重的,”他指出,并认为这个想法太慢且不切实际。

但图灵的许多想法已经被人们所接受。他说,在奖励和惩罚的帮助下,机器可以像孩子一样学习。有些机器可以通过重写自己的代码来修改自己。如今,机器学习、奖励和修改是人工智能的基本概念。

作为标志着思维机器进步的一种手段,图灵提出了模仿游戏,俗称图灵测试,它取决于人类是否能够辨别一组书面交流是来自人类还是机器。

这是一个巧妙的测试,但试图通过它却引发了巨大的混乱。在最近的一次令人惊讶的事件中,研究人员声称已经通过了一个聊天机器人的测试,该机器人自称是一名 13 岁的乌克兰人,养着一只宠物豚鼠,它会尖叫着贝多芬的《欢乐颂》。

吉罗拉米说,图灵对人工智能做出了另一项经常被忽视的重大贡献。这位科学家在布莱奇利公园工作期间的一篇解密论文揭示了他如何利用一种称为贝叶斯统计的方法来解码加密的消息。图灵和他的团队逐字逐句地使用统计数据来回答以下问题:“这个特定的德语单词生成这组加密字母的概率是多少?”

现在,类似的贝叶斯方法为生成式人工智能程序提供了动力,可以生成从未存在过的人物的文章、艺术作品和图像。 “在过去的 70 年里,贝叶斯统计数据出现了一个完整的平行宇宙,完全实现了我们今天看到的生成式人工智能,我们可以将其一直追溯到图灵在加密方面的工作,”吉罗拉米说。

“人工智能”一词直到 1955 年才出现。新罕布什尔州达特茅斯学院的计算机科学家约翰·麦卡锡在一份关于暑期学校的提案中使用了这个短语。他对进展前景极其乐观。

他写道:“我们认为,如果一组精心挑选的科学家一起工作一个夏天,就可以取得重大进展。”

“这是战后时期,”剑桥大学人工智能伦理学副教授 Jonnie Penn 博士说。 “美国政府明白核武器能够赢得战争。因此,科学技术不可能达到更高的高度。”

结果,聚集在一起的人取得了微不足道的进展。尽管如此,研究人员还是投入了构建程序和传感器的黄金时代,这些程序和传感器使计算机能够感知和响应环境、解决问题和规划任务,并应对人类语言。

计算机化的机器人在笨重的阴极射线管显示器上执行用简单的英语发出的命令,而实验室则演示了机器人在移动时会撞到桌子和文件柜。 1970 年,人工智能领域的杰出人物、麻省理工学院的马文·明斯基 (Marvin Minsky) 在接受《生活》杂志采访时表示,三到八年内,世界上将出现一台具有普通人一般智能的机器。它可以阅读莎士比亚、给汽车加油、讲笑话、玩办公室政治,甚至可以打架。几个月之内,通过自学,它的力量将是“不可估量的”。

泡沫在 20 世纪 70 年代破裂。在英国,著名数学家詹姆斯·莱特希尔爵士(Sir James Lighthill)针对人工智能的微薄进展撰写了一份措辞严厉的报告,引发了资金的立即削减。

这次复兴伴随着新一波科学家的到来,他们将知识视为解决人工智能困境的方法。

他们的目标是将人类的专业知识直接编码到计算机中。最雄心勃勃的——尽管也使用了其他词——是 Cyc。它的目的是掌握受过教育的人在日常生活中使用的所有知识。

这意味着要在批次中进行编码,但让专家解释他们如何做出决策并将信息编码到计算机中,结果比科学家想象的要困难得多。

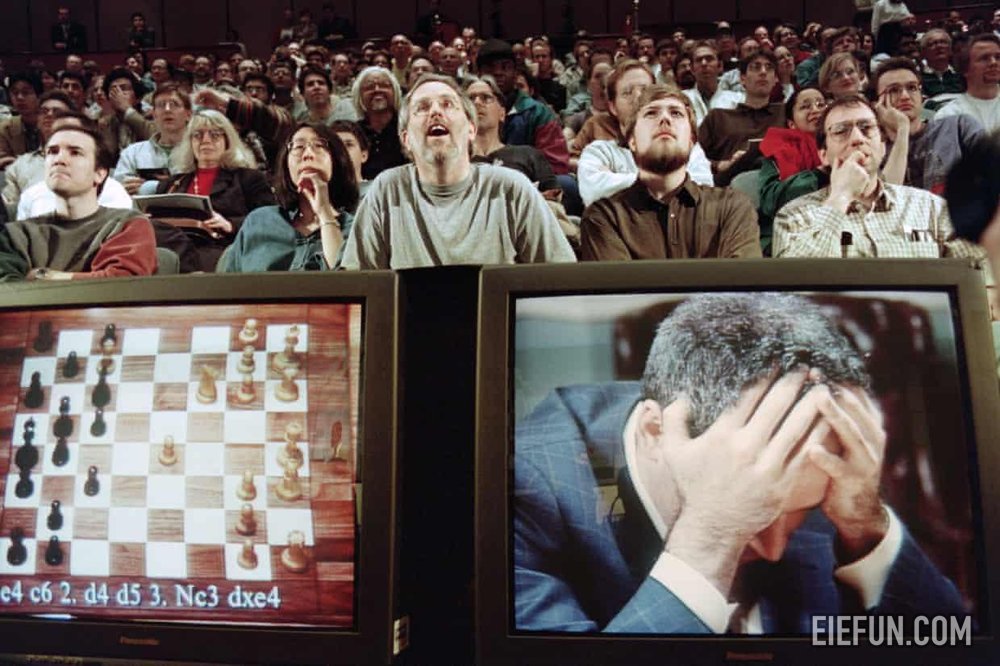

不过,二十世纪的人工智能确实取得了显着的成功。 1997年,IBM的深蓝击败了国际象棋大师加里·卡斯帕罗夫。这场竞赛成为了全球头条新闻,《新闻周刊》宣布“大脑的最后一战”。

在一场比赛中,深蓝每秒扫描 200m 个位置,并向前查看近 80 步。回忆起这场比赛,卡斯帕罗夫表示这台机器“发挥得像上帝一样”。

普林斯顿大学历史学教授、2023 年出版的《数据如何发生》一书的合著者马修·琼斯 (Matthew Jones) 表示:“从某种意义上说,这是更传统的人工智能模式的最后一次喘息。”

现实世界的问题更加混乱:规则不明确,信息缺失。会下棋的人工智能无法切换任务来计划你的一天、打扫房子或开车。 “国际象棋并不是人工智能的最佳基准,”谢菲尔德大学机器学习负责人 Eleni Vasilaki 教授表示。

自深蓝以来,人工智能领域最引人注目的飞跃来自于一种完全不同的方法,这种方法可以追溯到罗森布拉特和他的卡片分类感知器。基于感知器的简单单层神经网络并不是很有用:它们所能实现的目标存在根本限制。但研究人员知道多层神经网络会更有效。让他们遥不可及的原因是缺乏计算机能力以及对如何训练他们的了解。

这一突破出现在 1986 年,当时卡内基梅隆大学的杰弗里·辛顿 (Geoffrey Hinton) 等研究人员开发了“反向传播”作为一种教授网络的方法。现在,整个层可以相互通信,而不是单个“神经元”与邻居进行通信。

假设您构建了一个神经网络来对小猫图像和小狗图像进行分类。图像由网络的不同层输入并进行处理。每个层都会查看不同的特征,可能是边缘和轮廓或毛发和面部,并将输出发送到下一层。在最后一层,神经网络计算图像是猫或狗的概率。但假设网络误会了:罗弗永远不会在脖子上戴铃铛!您可以计算误差的大小并通过网络反向工作并调整神经元的权重(本质上是网络连接的强度)以减少误差。这个过程一遍又一遍地重复,这就是网络学习的方式。

这一突破使神经网络重新成为人们关注的焦点,但研究人员再次因计算能力和数据的缺乏而受阻。这种情况在 2000 年代发生了变化,出现了更强大的处理器,特别是用于视频游戏的图形处理单元,以及由于充满文字、图像和音频的互联网而产生的大量数据。另一个重大变化发生在 2012 年,当时科学家们证明,构建“深度”神经网络(具有很多层)的功能非常强大。 Hinton 等人推出了 AlexNet,这是一个包含约 10,000 个神经元的八层网络,它在 ImageNet 挑战赛中击败了对手,这是一项国际竞赛,挑战人工智能从数百万数据库中识别图像。

爱丁堡大学自然语言处理专家 Mirella Lapata 教授表示:“AlexNet 是让规模真正重要的第一课。” “人们过去认为,如果我们能够将我们所知道的有关某项任务的知识输入计算机,计算机就能够完成该任务。但想法已经转变。计算和规模比人类知识重要得多。”

AlexNet 之后,成果来得很快。谷歌的 DeepMind 成立于 2010 年,其使命是“解决智能问题”,推出了一种算法,可以从头开始学习玩经典的 Atari 游戏。通过反复试验,它发现了如何通过打破墙壁一侧的通道并将球送入后面的空间来在突破中取得胜利。另一种 DeepMind 算法 AlphaGo 在中国棋盘游戏中击败了围棋冠军李世石。该公司此后发布了 AlphaFold。在了解了蛋白质形状与其化学组成的关系后,它预测了 200m 以上的 3D 结构,几乎涵盖了科学上已知的所有蛋白质。这些结构现在正在推动医学科学的新浪潮。

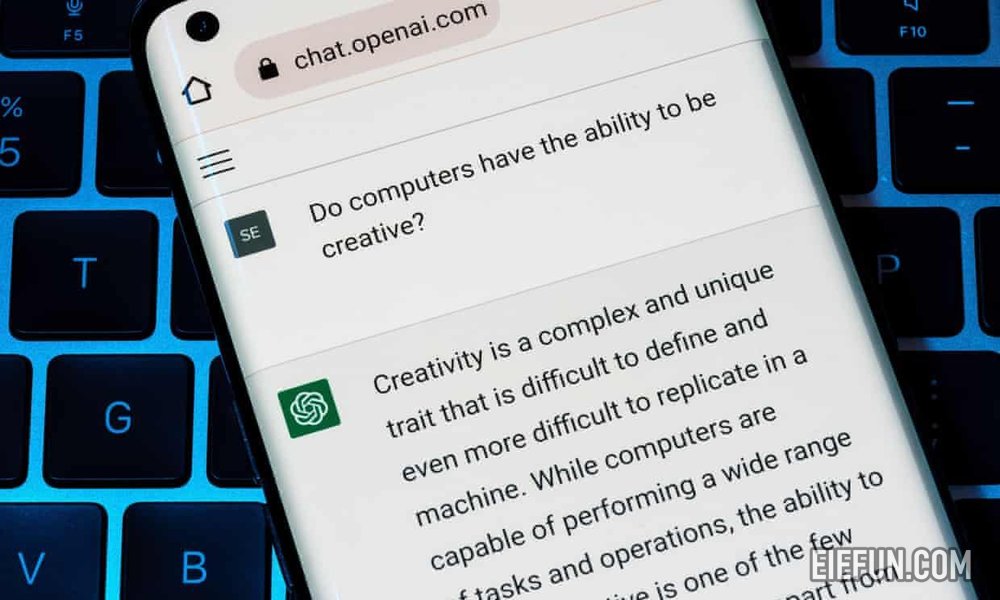

深度学习革命带来了大量的头条新闻,但现在这些看起来像是生成式人工智能掀起的浪潮之前的涟漪。以 2022 年发布的 OpenAI 的 ChaptGPT 为代表的强大新工具以其一代人的熟练程度命名:散文、诗歌、求职信、艺术品、电影、古典音乐。

生成式人工智能的核心引擎被称为变压器。它由谷歌研究人员开发,最初是为了改进翻译,在 2017 年的一篇论文中对其进行了描述,其标题《Attention Is All You Need》是对披头士乐队热门歌曲的即兴演绎。就连它的创造者似乎也低估了它所产生的影响。

Llion Jones 是该论文的合著者,也是该论文标题的负责人,此后离开谷歌,与他人共同创立了一家新公司 Sakana AI。他在东京的办公室里进行一项新的变压器实验,他在讲话中回顾了该论文的反响。 “我们确实认为我们正在创建一些非常通用的东西,它并不是专门为翻译而设计的。但我认为我们从未想过它会是这样的将军,它会接管,”他说。 “现在几乎所有东西都在变压器上运行。”

在 Transformer 出现之前,人工智能驱动的翻译通常通过逐个单词地处理句子来学习语言。这种方法有其缺点。按顺序处理单词的速度很慢,而且对于长句子也效果不佳:当到达最后一个单词时,第一个单词已经被忘记了。变压器在称为注意力的过程的帮助下解决了这些问题。它允许网络同时处理句子中的所有单词,并在其周围的上下文中理解每个单词。

OpenAI 的 GPT(代表“生成式预训练变压器”)和类似的大型语言模型可以生成冗长而流畅(即使并不总是完全可靠)的文本段落。他们接受了大量数据(包括互联网上的大部分文本)的训练,学习了以前算法无法识别的语言特征。

也许最引人注目、最令人兴奋的是,变形金刚可以将他们的手转向广泛的任务。一旦它了解了所输入数据的特征(音乐、视频、图像和语音),就可以提示它创作更多数据。变压器不需要不同的神经网络来处理不同的媒体,而是可以处理很多事情。

“这是一个阶段性的改变。这是一个真正的技术分水岭时刻。”牛津大学计算机科学教授、《通往意识机器之路》一书的作者 Michael Wooldridge 说道。 “显然谷歌没有发现潜力。我很难相信,如果他们明白这将是我们迄今为止看到的最重要的人工智能发展,他们会发布这篇论文。”

伍德里奇看到了闭路电视的应用,变压器网络可以在犯罪发生时发现它们。 “我们将进入一个生成式人工智能的世界,猫王和巴迪·霍利将在其中起死回生。如果你是原版《星际迷航》系列的粉丝,生成式人工智能将根据你的喜好创作任意多的剧集,配音听起来像威廉·夏特纳和伦纳德·尼莫伊。你将无法分辨出其中的区别。”

但革命是有代价的。像 ChatGPT 这样的训练模型需要大量的计算能力,而且碳排放量也很大。佩恩表示,生成式人工智能“让我们陷入了与气候危机的冲突”。 “与其过度设计我们的社会,让它每天都在人工智能上运行,不如让我们把它用在有用的地方,而不是把时间浪费在无用的地方。”

免责声明

本文内容(图片、文章)翻译/转载自国内外资讯/自媒体平台。文中内容不代表本站立场,如有侵权或其它,请联系 admin@eiefun.com,我们会第一时间配合删除。