设计师如何引领人类创造人工智能的道路。

“要么你可以成为变革的一部分,要么世界可以在没有你的情况下被设计,然后你必须适应这种变化。”

— 布莱恩·切斯基 (Brian Chesky),接受 DeZeen 采访

人工智能(AI)的快速崛起伴随着伦理和社会问题。随着人工智能越来越融入我们的日常生活,这些问题,从数据集的偏差到大规模工作岗位流失的可能性,都变得越来越不可避免。但希望并没有消失。以人为中心的人工智能——公平、透明和有益的人工智能——只要有意图地设计就可以实现。

作为用户体验专业人士,我们拥有独特的优势来创建补充和增强人类能力的人工智能系统。

为了影响人工智能产品的开发,设计师需要对人工智能有基本的了解。我们不需要机器学习方面的博士学位,但我们必须有见多识广的从业者,他们知道机器学习是如何工作的以及它能做什么。

学习人工智能就像学习投资一样。乍一看,这似乎令人难以置信——wtf 是一只“ETF”。然而,随着缩写和流程变得熟悉,它变得不再神秘。也就是说,在罗斯 IRA 中进行经常性投资和在摩根大通担任股票经纪人(至少我是这么被告知的)之间仍然存在区别。就像你不需要成为一名股票经纪人来明智地投资一样,你不需要成为一名计算机科学家来有效地创建人工智能驱动的工具。

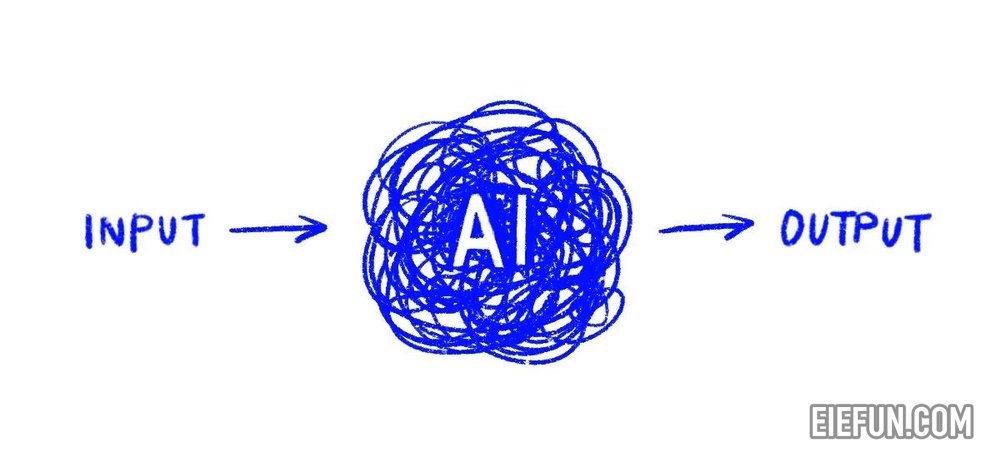

从广义上讲,人工智能是指计算机模仿人类思维的能力,而机器学习(ML)是人工智能的一个子集,它允许系统从数据中学习。

与每个函数都被显式编码的传统编程不同,机器学习模型从训练数据集中学习模式。经过训练后,这些模型会根据输入生成输出,充当“黑匣子”,过程相当不透明。

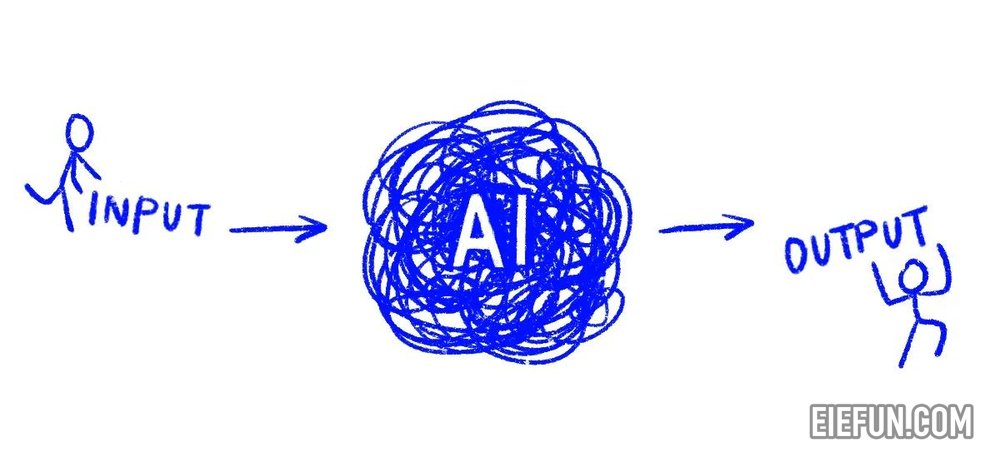

人类交互发生在这些输入和输出阶段。以人工智能的三种不同用途为例:

- 欺诈检测 (ML):

输入 = 交易数据,输出 = 欺诈判定。 - 健康检查(机器学习、计算机视觉):

输入 = 图像,输出 = 健康分析或测量。 - 对话式人工智能(ML、生成式人工智能、自然语言处理):

输入 = 文本提示,输出 = 生成的响应

有许多在线资源可以帮助设计人员掌握这些基础知识,为我们的问题解决工具包添加重要工具。

在理想情况下,设计师从发现阶段开始就参与人工智能开发底层的产品开发。这是我们评估人工智能是否对于我们的产品实现其预期目标是否必要的地方。

这是我们的第一个影响点:以与任何其他工具相同的审查方式评估人工智能,关注用户需求而不是技术的华而不实。

以下是一些有用的问题,可帮助人工智能解决方案立足于用户需求:

- 人工智能是解决已识别问题的正确解决方案吗?

- 该模型如何集成到现有的用户工作流程中?

- 现有的工作流程能否及时为模型提供必要的数据?

- 需要如何呈现模型输出才能成为有效的解决方案?

这就是为什么对人工智能的工作原理有一个基本的了解很重要,因为它将帮助我们做出明智的判断,判断它是否真的是一个合适的解决方案。

最终,尽早参与可以确保人工智能解决方案适应用户,而不是相反。

基本的人工智能素养还使设计人员能够与机器学习工程师等跨职能团队成员有效协作。最终,尽早参与可以确保人工智能解决方案适应用户,而不是相反。对风险和道德考虑的讨论可以提供在产品开发周期中纳入评估的机会。

你们中的一些人可能会想“这很好,但太理想化了——在其他利益相关者已经决定使用人工智能之后才引入设计”。然后呢?

当人工智能解决方案预先确定时,设计人员仍然可以通过关注输入和输出(用户与人工智能直接交互的两个领域)来影响结果。

输入设计

输入取决于人工智能的类型。无论格式如何,输入收集方法必须直观且用户友好。应用既定的设计原则——尤其是可供性——可以使用户操作清晰且轻松。

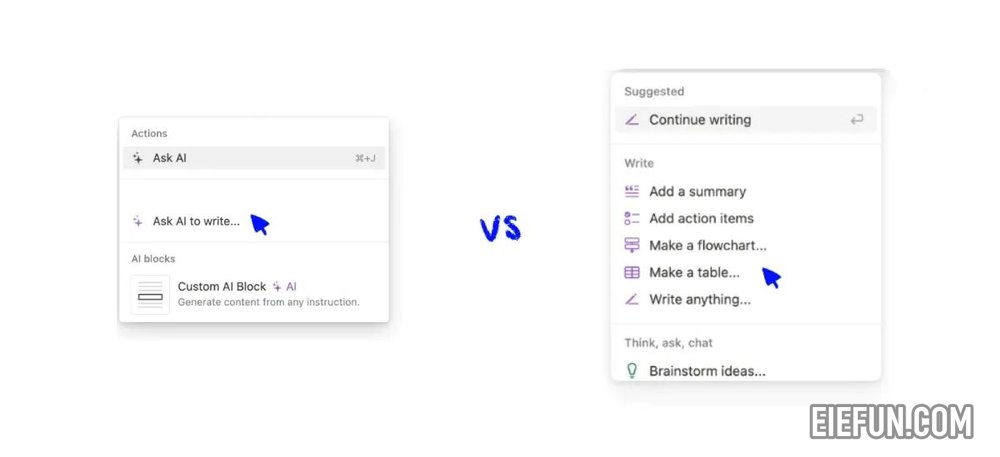

良好的输入设计使输入操作非常简单易懂。让我们回顾一下这三个例子:

- 欺诈预防输入:尽可能自动化数据收集,以简化工作流程并最大限度地减少用户工作量。

- 健康筛查输入:提供清晰的说明以捕获正确的图像,并在需要调整时提供实时反馈。

- GenAI 输入:提供一组特定的可能命令,帮助用户了解可以使用该产品做什么。正如产品设计师 Maggie Appleton 所说, “我们应该用模型制作微小、锋利、特定的工具。”通过为用户提供可供选择的选项,这有助于减少空白画布文本输入字段的瘫痪。

用户研究提供了有关工作流程、痛点和期望的见解。通过利用这些知识,我们可以设计简化的体验,自动执行任何重复性任务,以节省用户的时间和精力。此外,在紧密的迭代周期中进行频繁测试可以尽早发现摩擦点,从而实现持续改进并创建真正用户友好的人机交互。

输出设计

与设计输入类似,当涉及到设计输出时采用的设计方法时,我们不必重新发明轮子。人机交互考虑因素可以转化为人机交互。

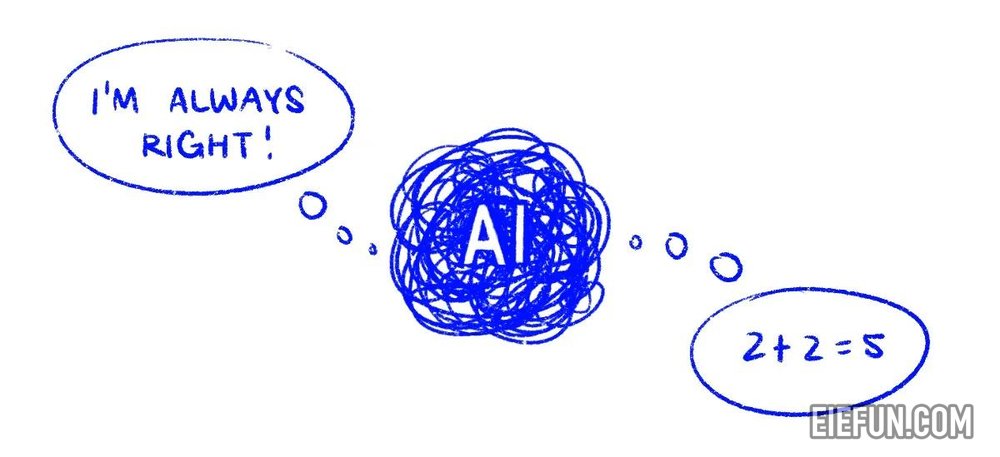

人工智能输出设计中最重要的事情是强调人工智能的易错性并减少自动化偏差。截至目前,人工智能远非它看上去那么容易成为的真理仲裁者。

这里的关键问题是确定如何向用户传达潜在的人工智能缺陷。确切的设计将取决于具体情况,但以下是与这三个示例相关的一些潜在途径:

- 欺诈检测输出:仅专注于发送关键通知,避免不必要的警报让用户不知所措。这可以防止警报疲劳——即人们在接触大量警报后变得不敏感

- 健康筛查仪输出:显示置信度分数或不确定性指标。例如,“80% 的置信度”会引起人们对模型潜在局限性的关注,鼓励用户应用他们的专业知识。

- GenAI 输出:包括参考文献或引文,以允许用户验证信息。避免将输出呈现为确定的。

通过将人工智能定位为一种工具而不是权威,用户有权做出明智的决策。

最后,系统地思考:我们与人工智能工具的交互并不会在输出点结束。用户接下来需要采取哪些行动?我们如何制定解决方案来促进支持的工作流程从开始到结束?

如果不解决伦理问题,任何以人为中心的人工智能的讨论都是不完整的。设计师必须倡导透明度、公平性和包容性。

应尽早提出偏见、数据隐私和意外后果等问题,并在整个产品生命周期中经常重新审视这些问题。在开发过程中投入时间进行评估并不是一种奢侈,而是一种必要。

这些对话将是艰难的,因为它们常常直接损害公司的潜在利润,但这使得它们变得更加必要。

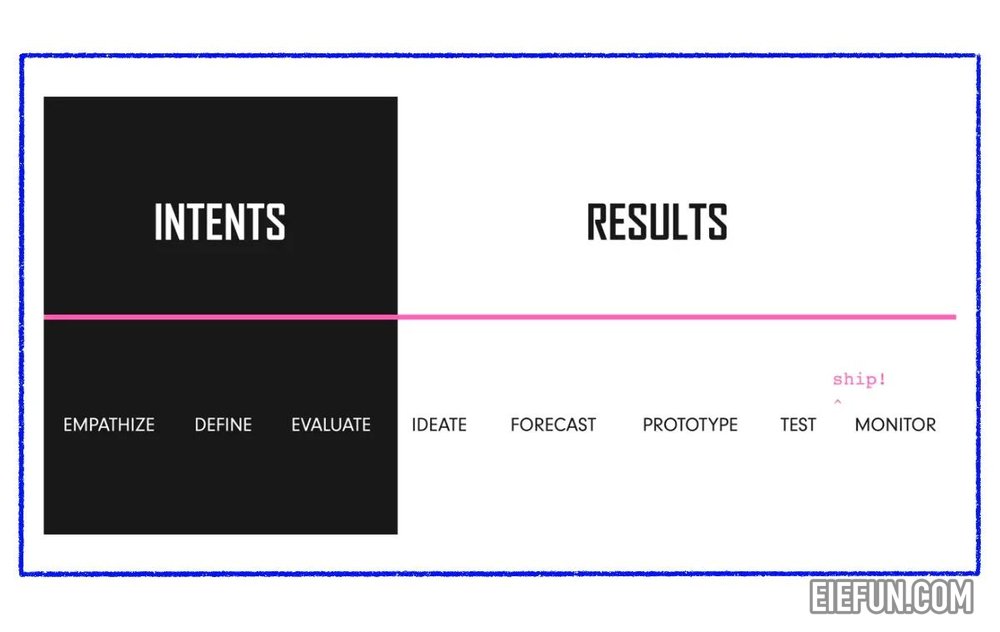

周凯的框架是评估产品意图、预测潜在结果和监控可能出现的任何问题的一个很好的起点。

正如布莱恩·切斯基(Brian Chesky)在同一次采访中提到的那样, “最好的机会是让最具创造力的人、负责的人文主义者参与这场看似不可避免的革命。”

用户体验领导者应该致力于成为何时以及如何使用人工智能的决策者。如果现在不可能,请从精心设计以人为本的人工智能设计并制定长期产品愿景开始。建立影响力,以便将来您可以在众所周知的桌子上占据一席之地,并从一开始就指导决策。

人工智能本身无法解决我们的问题。我们必须积极塑造它,以公平和负责任的方式满足人类的真正需求。让我们带头冲锋吧。

版权声明

本文为本站原创内容,转载需注明文章来源(https://www.eiefun.com),另:文中部分素材可能会引用自其他平台,如有侵权或其它,请联系 admin@eiefun.com,我们会第一时间配合删除